生成AIを自社でも使ってみたい、スモールスタートしたい、でも情報漏洩が心配だ、使えば使うほどコストがかかる ・・これらを解決するのが、ローカル環境に構築するLLM「ローカルLLM」ですが、どのくらいのPCスペックが必要でしょうか。当社の環境でざっくり調べてみましたので、参考になさって下さい。

GPUはやはり必要

結論から言いますと、低スペックでもよいのでGPUさえ搭載されていれば、そこそこ動きそうです。

通常業務で使うPCですと、例えばオフィス文書の作成とか、Webブラウジングとか、オンライン会議とか、そういう用途が多いでしょうから、多くの場合それほど高スペックではないでしょう。ここ数年で発売されたノートPCをお使いの方が多いかもしれません。しかし残念ながら、そのような一般的なノートPCでは、(ローカル環境で)生成AIを使うことは難しそうという結果でした。

検証結果

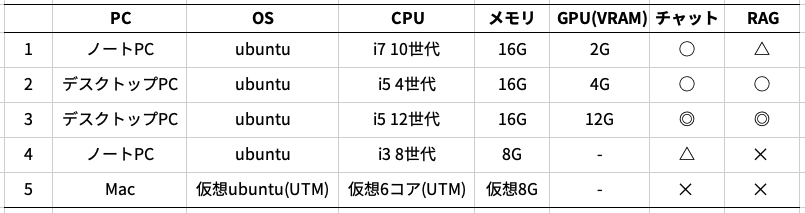

以下の表は、今回トライしたPC環境とその結果です。ノート、デスクトップ、仮想環境、システムメモリは8〜16GB、GPUの有無とVRAM容量、これらの違いを見ています。LLMは基本的にllama3.1 8Bを使っていますが、No.4のノートPCのみllama3.2 3Bを使いました。Docker上でDify、ollamaを動かしてテストしています。結果はマルバツで示していますが、ざっくり次のとおりです。◎:はやい、◯:まぁまぁ、△:ギリギリ、✕:遅過ぎ。

✕は動かなかったわけではなく、極めて遅いという状態です。やはりGPUのない環境ですと、実使用に耐えません。業務用途で一般的?と思われるNo.4のノート環境では、llama3.2のチャットはまぁまぁ動いていますが、RAGは遅過ぎて使い物になりません。また、No.5のMacの仮想環境ではチャットもおぼつかない感じです。

一方、GPUのある環境なら、どの条件もそこそこ使えています。No.1~3いずれもNvidiaのGPUですが、VRAM 2GBでもRAGも含め概念検証ならいけそうな印象です。VRAM 4GBなら、もう少し快適に使えます。VRAM 12GBなら、商用サービスと同じような速度で使えます。システムメモリはいずれも16GBですが、あまり影響していないようです。重要なのはVRAMです。No.1と2は、いずれも低スペックなGPUですが、搭載されていない環境に比べれば雲泥の差です。(因みに、llama3.1 70Bは、VRAM 12GBでも動きません)

まとめ

限られた環境ではありますが、ローカルLLMのざっくりとした感触をお伝えしました。現時点では、今お使いのPCに環境をつくればすぐに使える、というものではなさそうです。GPU付きのノートPCを用意するか、デスクトップPCをお持ちならGPUを追加すれば、RAGを含めそこそこの環境がつくれます。GPUは、そこまで高性能である必要はなく、低スペックなものでもスモールスタートは切れそうです。今なら、RTX 3060がコスパがよくおすすめです(VRAMも12GB)。以上、参考にしていただければ幸いです。